La irrupció de la postveritat

Facebook o Fakebook

Les xarxes socials ens estan acostumant a la desintermediació informativa al rebre els continguts

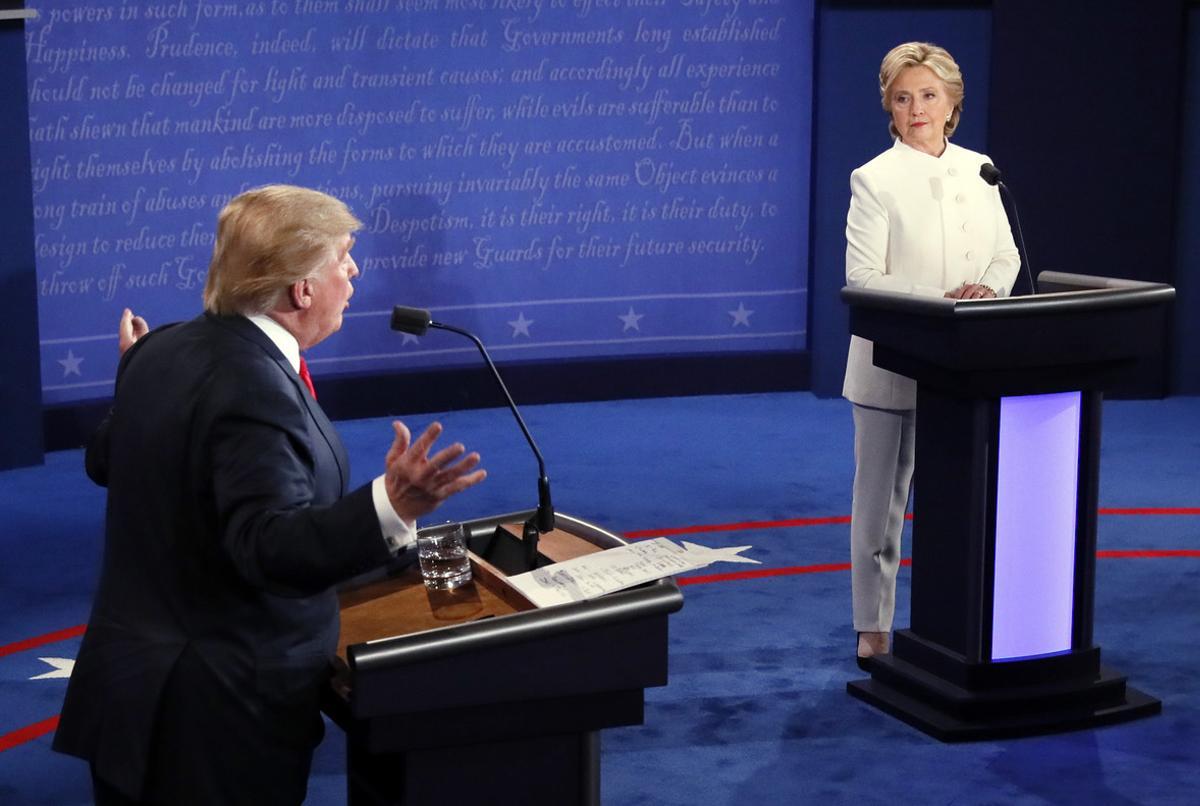

hillary1 /

El risc, i l'amenaça, de viure atrapats per un algoritme és real. El placebo digital que generen les bombolles informatives és tan sedant com artificial. I perillós. Alimenta els nostres prejudicis, oferint continguts que han sigut identificats com a convenients -perquè són complaents i dòcils- per a les nostres conviccions. Segrestada la nostra capacitat d'elecció conscient, ens sumim en un entorn d'autoafirmació, cada vegada més excloent i reverberant. El ressò s'apodera de la conversa. I el que escoltem no són altres veus -altres arguments, altres dades, altres idees-, sinó la nostra pròpia veu.

En l'última campanya electoral nord-americana vam viure, intensament, en una bombolla de continguts generada automàticament per algoritmes que processen big data electoral. La robotització de la comunicació política s'ha consolidat de manera extraordinària. Dels trolls als bots. L'important era alimentar l'engagement (l'activitat i interacció constant de l'internauta amb l'oferta de continguts) dels electors i activistes digitals, incloent notícies equívoques, inexactes... El fet que la difusió de notícies falses a Facebook generés reafirmació agitada entre els seguidors de Donald Trump, per exemple, va ser el resultat lògic de l'aplicació de les tècniques denominades black hat (posicionament artificial en xarxes per aconseguir rellevància i influència).

A més a més, s'ha de tenir en compte una altra dada important: gairebé el 50% dels nord-americans es van informar sobre les eleccions presidencials a través de Facebook. És un efecte directe de la desintermediació informativa a la qual les xarxes socials ens estan acostumant al rebre els continguts. Aquestes bombolles d'informació o filter bubble influencien els usuaris, perquè els contaminen. Acaben oferint-los continguts en funció de les seves preferències i les dels seus contactes. Aquesta situació agreuja l'aïllament informatiu, i irromp la postveritat (paraula de l'any per al Diccionari Oxford), en què les informacions rigoroses tenen menys influència que les creences i les emocions personals. El prejudici és més reconfortant que el judici. Facebook ja va realitzar proves alterant el subministrament de notícies en determinats usuaris per comprovar si al rebre notícies positives o negatives, ells també canviaven el seu estat d'ànim. El resultat va ser que sí, que els usuaris són influenciables. El mateix va succeir amb The Guardian, que va realitzar un experiment amb diversos lectors. El resultat va ser alarmant.

Les xarxes, sobretot Facebook, estan començant a reaccionar per por de la reputació. Al mes d'octubre, Facebook i Twitter es van unir a la iniciativa de Google, First Draft Coalition, amb l'objectiu de combatre la difusió de notícies falses. I, dies abans de les eleccions nord-americanes, Facebook va implementar un sistema de suspensió automàtica per evitar la difusió d'aquests continguts. Però aquesta capacitat discrecional també pot servir per a altres pràctiques com l'elaboració de llistes negres, les sospites de partidisme i, en definitiva, la ruptura de la neutralitat de la xarxa en pro de la veracitat informativa. En aquesta línia, The New York Times ha revelat que Facebook estaria provant una eina per ocultar determinades informacions per zones geogràfiques, amb l'objectiu d'acontentar el règim xinès.

Sent Facebook un mitjà de referència per a molts usuaris, i veient la possible influència que podia haver tingut en el resultat de les eleccions nord-americanes, molts usuaris van realitzar crítiques sobre la permissivitat en la publicació d'aquestes notícies. Arran d'aquestes crítiques, Mark Zuckerberg va publicar una nota en què exposava set mesures per mirar d'aturar el problema. Aquestes mesures proposen reforçar els algoritmes per a la detecció de notícies falses, facilitar la denúncia per part dels usuaris, oferir informes sobre elles, poder qualificar-les com a dubtoses, donar més visibilitat a continguts de referència i atacar els ingressos que siguin generats per informacions falses. Però l'alteració dels algoritmes podria modificar una de les principals fonts d'ingressos de Facebook: l'enorme pastís de la inversió publicitària segmentada. ¿Com resoldran aquest conflicte d'interessos?

Estem en un moment crucial. Prevenir-nos de l'algoritme que ens sedueix i redueix, perquè ens converteix en addictes dels nostres propis prejudicis, és clau si volem una societat més connectada però més lliure.